“El SEO consiste en facilitarles y gustarle lo máximo posible a los motores de búsqueda, para que éstos posteriormente mejoran tu posicionamiento” Es una frase que resume el significado de lo que consiste la optimización de los motores de búsqueda, pero inicio el post con ella, por la mera razón de que hay más factores de los básicos OnPage que se han de tener en cuenta para que los buscadores consigan ver lo bien que está una web; ya que no sirve de nada optimizar una web, si el motor de búsqueda no la puede tener en cuenta.

Con el fin de mejorar el Posicionamiento SEO, son muchos los factores de OnPage que se han de tener en cuenta a la hora de optimizar el SEO de una web para parecerle lo más “sexy” posible a los robots de los motores de búsqueda. Y siempre son los metas tags, la densidad de las keywords o la velocidad de carga entre otros factores los que mayor importancia damos, pero hay un factor que es de los más importantes, que muchas veces se olvida.

Si lo que queremos es parecerle lo más “sexy” posible a Google, ¿de qué sirve ponernos las mejores galas, con una optimización OnPage de 10, si luego Google no consigue vernos o tenernos en cuenta? Aquí está el quid de la cuestión, ese factor que siempre, y digo siempre se ha de tener en cuenta a la hora de optimizar una web de cara a los motores de búsqueda.

Este factor es el conocido “Crawl Budget” o presupuesto de rastreo. ¿Y de qué se trata?

Empezaremos explicando qué es un crawler y cuál es su principal función.

¿Qué es un crawler?

El crawler o araña web, es una especie de software que no cesa de recorrer o rastrear la red, detectando todos los enlaces y páginas accesibles y recopilando toda la información que las webs muestran, para seguidamente almacenar la información en los servidores de Google. Una vez que hayas recopilado toda la información, la administran y clasifican, y según los parámetros de sus algoritmos internos, dan orden a su índice que se muestra en los resultados de búsquedas que posteriormente ven los usuarios al buscar algo.

Los crawlers de los principales motores de búsqueda son los siguientes:

- Googlebot – Google

- Slurp – Yahoo

- Bingbot – Bing

- Duckduckbot – DuckDuckGo

- Baiduspider – Baidu

- Yandexbot – Yandex

Vale, y ahora que sabemos qué es un crawler y cuáles son los principales, vamos a ver qué es el Crawl Budget, ¡empecemos!

¿Qué es el Crawl Budget?

El Crawl Budget es el tiempo que asigna Google a los rastreadores para que analicen una web, por lo que si tu web tiene un Crawl Budget de 2 segundos, este será el tiempo que el rastreador dedicará cada día que analice tu web. El tiempo de rastreo lo designa según los criterios de accesibilidad, velocidad de carga, autoridad y la calidad del sitio. ¿Y por qué es tan importante este tiempo? La respuesta es muy sencilla; si tu Crawl budget es de 1,6 segundos y tu web tiene más de 2000 páginas, el rastreador tan solo tendrá ese tiempo para rastrear toda la web, y tal vez al ser tantas páginas, el tiempo de rastreo se quede corto, por lo que algunas páginas no las llegará a tener en cuenta.

Por ello el Crawl Budget es tan importante para el Posicionamiento SEO, ya que si no llega a rastrear la totalidad de páginas de una web, aquellas páginas que no han llegado a ser rastreadas es muy probable que no lleguen a posicionar tan bien como otras que sí han sido rastreadas.

Bien, y ahora que sabemos qué es un Crawler y el Crawl Budget, os preguntaréis ¿y los logs qué pintan en este tema, qué importancia tienen para el SEO? Pues empecemos definiendo bien el significado de un Log.

¿Qué es un log y para qué sirven?

Un Log es aquel registro que se almacena información en forma de texto cada vez que se hace una petición al servidor de una web. Todos los cambios que se aplican en una web, se almacenan a medida que se van realizando acciones o cambios en el sistema. Estos archivos se caracterizan por ser como huellas o pistas que se dejan, y sirven de mucho para que puedas analizar aquellos cambios que se han hecho sobre un sistema. Con los logs se pueden detectar aquellos errores o incidencias que hubieron en una web, para así poder ver cuándo se han realizado y de esta manera, poder ver su porqué.

A modo de ejemplo práctico, si nuestra web durante la noche ha fallado, provocando diversos fallos de acceso con errores 404, con los logs podemos ver a qué se han debido tales errores, ya que habrán quedado registrados.

¿Y qué relación tienen los Logs con el SEO?

Como hemos dicho anteriormente, es muy importante conocer cuál es el Crawl Budget la igual que conocer cómo y con qué frecuencia los bots rastrean una página web. Para ello existe una herramienta sumamente útil como es Screaming Frog Log File Analyser, que puede aportarnos datos fundamentales como cuáles son para los Bots las páginas más importantes o la frecuencia de rastreo.

Gracias a los Logs, podremos detectar aquellos fallos de estructuración de una web, al conocer aquellas páginas que no se llegan a rastrear, al igual que podremos conocer la razón de porque alguna página no consigue rankear bien, ya que tal vez sea porque no es accesible para los bots de los motores de búsqueda. También podremos revisar si funcionan correctamente las redirecciones que haya establecidas, al poder verse qué lectura hacen de ellas los crawlers.

¿Y qué datos aportan los Logs?

Mediante Log Analyser de Screaming Frog, podremos conocer todos estos datos:

- Enlaces rotos o errores.

- La frecuencia o el número de veces que un bot pasa por la web.

- Los códigos de respuesta (200, 301, 404, 505…etc).

- Desde qué IP están entrando los Bots al hacer el crawler y los bytes que han usado

- Identificar a los Bos por el User Agent.

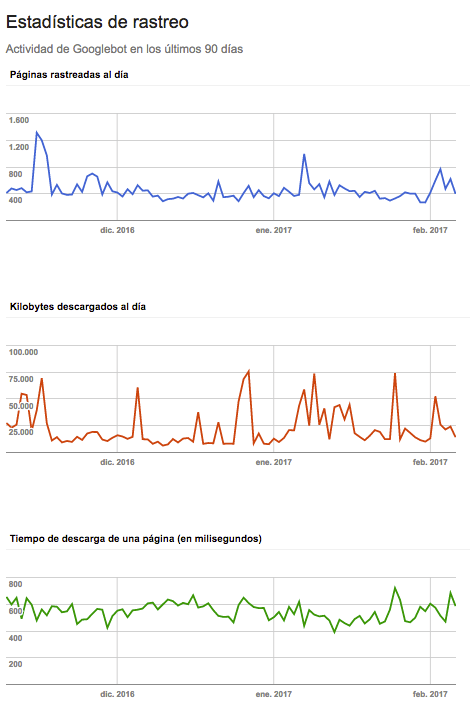

Cómo podéis ver, es muy importante ser “sexys” a la vez que accesibles para los motores de búsqueda si lo que queremos es mejorar nuestro Posicionamiento Orgánico. Para ello, se recomienda que a menudo se revise el Crawl Budget, y se analice desde Search Console las Estadísticas de Rastreo para conocer cómo está siendo rastreada la web por parte de Google y los diferentes buscadores. Aquí podéis ver un ejemplo de las estadísticas de rastreo de una web desde Search Console.

Con todo esto, me despido y espero os haya servido de mucho el post para mejorar vuestra estrategia SEO y podáis rankear cada vez mejor mediante esta técnica SEO.